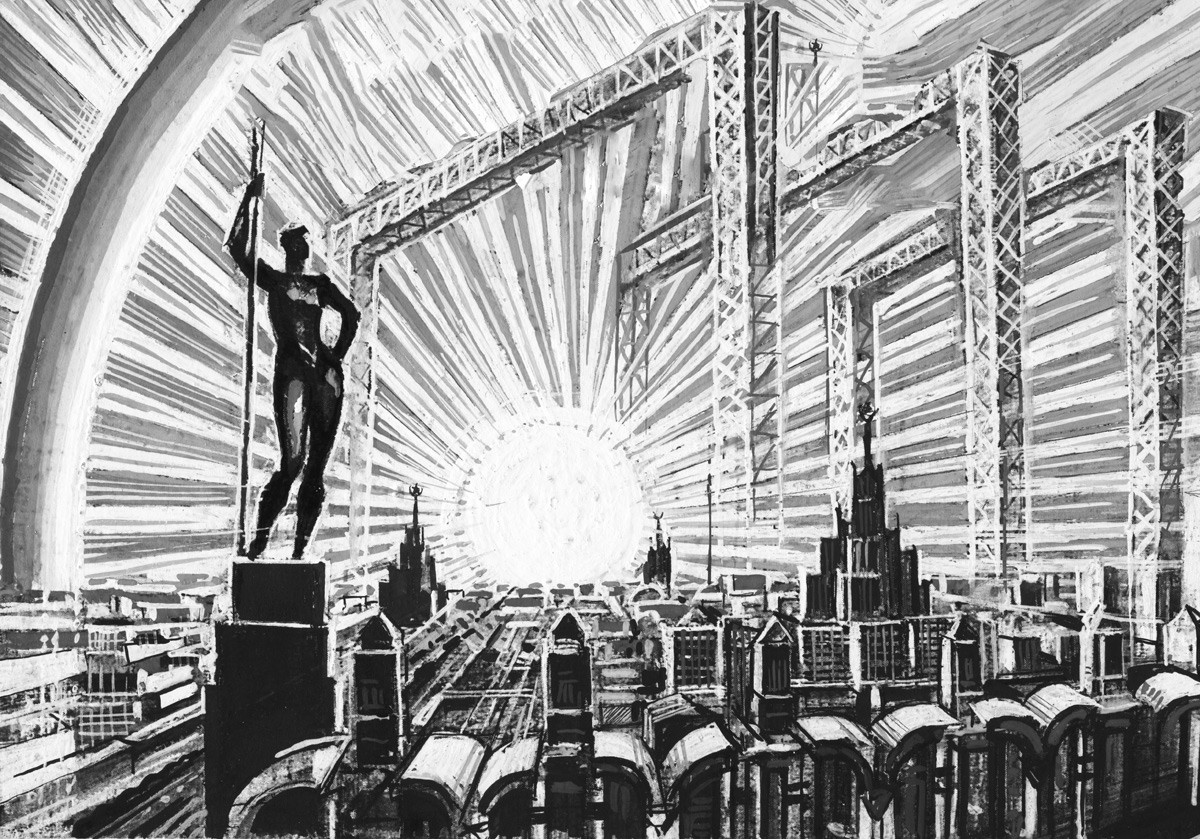

Учёные предполагают, что человечество может достичь сингулярности в течение следующих трех месяцев

«Мир переполнен прогнозами о том, когда наступит сингулярность (гипотетический момент, когда технологическое развитие становится неуправляемым – Е.Л., В.О.) или когда появится Общий искусственный интеллект (ОИИ). Некоторые эксперты предсказывают, что этого никогда не произойдёт, в то время как другие отмечают в календарях 2026 год», - пишет Popular Mechanics (02.10.2025).

Новый макроанализ опросов за последние 15 лет показывает позицию ученых и отраслевых экспертов по этому вопросу и то, как со временем менялись их прогнозы, особенно после появления крупных языковых моделей, таких как ChatGPT.

Хотя прогнозы разнятся на протяжении почти полувека, большинство сходятся во мнении, что ОИИ появится до конца XXI века.

С появлением больших языковых моделей (LLM), которые теперь проникли, кажется, во все уголки нашей цифровой жизни, ученые, эксперты, лидеры отрасли и практически все остальные имеют свое мнение об ИИ и о том, в каком направлении он будет развиваться.

Некоторые исследователи, изучающие возникновение машинного интеллекта, полагают, что сингулярность — теоретическая точка, в которой машина превзойдет человека по интеллекту, — может наступить в течение десятилетий.

На другом конце спектра прогнозов находится генеральный директор Anthropic, который считает, что мы находимся прямо на пороге — дайте нам еще около 3 месяцев.

У ИИ-ботов есть секретные языки

Новый анализ, основанный на «прогнозах 8590 учёных, ведущих предпринимателей и представителей сообщества», пытается разобраться во всех запутанных прогнозах ИИ, существующих сегодня, и отследить изменения в этих прогнозах с течением времени. Это макроисследование было проведено исследовательской группой AIMultiple, которая оценивает новые технологии, используя надёжные методы анализа данных.

Хотя в этом опросе рассматриваются различные пороговые значения ИИ (например, общий искусственный интеллект (ОИИ) и сверхинтеллект ИИ), лидеры отрасли ИИ в целом были более оптимистичны в своих прогнозах. Однако большинство респондентов считают, что ОИИ, вероятно, появится в течение следующих полувека.

«Согласно текущим опросам исследователей искусственного интеллекта, появление ОИИ ожидается примерно к 2040 году», — говорится в докладе. «Однако всего за несколько лет до стремительного развития больших языковых моделей (LLM) учёные предсказывали его появление примерно к 2060 году. Предприниматели настроены более оптимистично, прогнозируя его появление примерно к 2030 году».

Макроанализ также проливает свет на то, почему многие эксперты считают появление ОИИ неизбежным. Во-первых, это идея о том, что, в отличие от человеческого интеллекта, машинный интеллект, по всей видимости, не имеет каких-либо ограничений — по крайней мере, пока не выявленных. Поскольку вычислительная мощность удваивается каждые 18 месяцев (концепция, известная в компьютерной инженерии как закон Мура), LLM должны быстро достичь порога вычислений в секунду, сопоставимого с человеческим интеллектом. В докладе также говорится, что, если вычислительная техника когда-либо столкнётся с каким-либо инженерным барьером, квантовые вычисления, возможно, помогут её преодолеть.

«Большинство экспертов считают, что закон Мура подходит к концу в этом десятилетии», — говорится в докладе. «Уникальная природа квантовых вычислений может быть использована для эффективного обучения нейронных сетей, которые в настоящее время являются самой популярной архитектурой ИИ в коммерческих приложениях. Алгоритмы ИИ, работающие на стабильных квантовых компьютерах, имеют шанс раскрыть сингулярность».

Однако не все считают, что существование ИИ является абсолютной реальностью. Некоторые эксперты утверждают, что человеческий интеллект гораздо более многогранен, чем то, что описывает современное определение ИИ. Например, некоторые специалисты по ИИ рассматривают человеческий разум в терминах восьми видов интеллекта, из которых «логико-математический» — лишь один (наряду с ним существуют, например, межличностный, внутриличностный и экзистенциальный интеллект).

Пионер глубокого обучения Янн Лекун считает, что ИИ следует переименовать в «продвинутый машинный интеллект», и утверждает, что человеческий интеллект слишком специализирован для воспроизводимости. В докладе также говорится, что, «хотя ИИ может быть важным инструментом для совершения новых открытий, он не может совершать эти открытия самостоятельно».

«Более высокий уровень интеллекта может привести к более качественному планированию и управлению экспериментами, что позволит делать больше открытий за один эксперимент», — говорится в отчёте. «Даже самая лучшая машина, анализирующая имеющиеся данные, может оказаться неспособной найти лекарство от рака».

Хотя отдельные прогнозы экспертов и ученых относительно ИИ разнятся на протяжении примерно полувека, послание ясно: человеческое общество неизбежно столкнется с невероятными изменениями в результате действия этих алгоритмов.

В 2024 году агентство Reuters сообщило, что компании, занимающиеся искусственным интеллектом, больше не фиксируют ранее наблюдавшегося экспоненциального роста возможностей искусственного интеллекта. «Закон масштабирования» ИИ — идея о том, что большие наборы данных и больше ресурсов будут делать модели все лучше и лучше — больше не работал. Это натолкнуло некоторых экспертов на мысль о том, что необходимы новые инновации, чтобы продвинуть эти модели еще дальше. Это новое исследование предполагает, что интеграция внутриуровневых связей и циклов обратной связи может позволить моделям соотносить, отражать и уточнять результаты, делая их более интеллектуальными, а также более энергоэффективными.

«Одно из заблуждений заключается в том, что наша точка зрения просто предлагает «больше сложности», — говорит Ван. «Наша цель — структурировать сложность, добавить измерения и динамику, которые отражают то, как интеллект возникает в природе и работает логически, а не просто нагромождать больше слоев или параметров».

Одним из увлекательных примеров того, как авторы предлагают добавить эту сложность, являются петли обратной связи с «фазовыми переходами», которые будут способствовать разумному поведению. Основная идея заключается в том, что эти переходы могут создавать новые модели поведения, которые изначально отсутствовали в отдельных компонентах системы. Подобно тому, как лед тает в воде, системы искусственного интеллекта могут «эволюционировать» до стабильного состояния.

«Для ИИ это может означать, что система перейдет от расплывчатых или неопределенных выходных данных к уверенным, согласованным по мере того, как она собирает больше контекста или обратной связи», — говорит Ван. «Эти переходы могут отметить точку, где ИИ действительно «понимает» задачу или закономерность, подобно тому, как срабатывает человеческая интуиция».

Петли обратной связи и внутриуровневые связи, которые имитируют способы, которыми человеческий разум приходит к пониманию и смыслу, недостаточны для того, чтобы мгновенно возвестить об эре ОИИ. Но, как упоминает Ван в своем исследовании, эти методы могут помочь вывести модели ИИ на шаг вперед за пределы архитектуры трансформеров, что является решающим шагом, если мы когда-нибудь надеемся достичь «Святого Грааля» исследований ИИ.

«Введение большего количества функций, подобных мозгу, в архитектуру ИИ может не только сделать ИИ более прозрачным (т.е. мы будем знать, как ИИ пришел к определенным выводам), но и помочь нам исследовать таинственную и сложную головоломку того, как работает наш собственный разум». Авторы отмечают, что это приложение может предоставить ученым модель для изучения человеческого познания, а также для изучения неврологических расстройств, таких как болезнь Альцгеймера и эпилепсия.

Несмотря на то, что вдохновение от биологии человека приносит пользу, Ван видит будущее ИИ как будущее, в котором нейроморфные архитектуры, такие как человеческий мозг, сосуществуют с другими системами.

«Искусственный интеллект, вдохновленный мозгом, предлагает элегантные решения сложных проблем, особенно в области восприятия и адаптивности. Между тем, ИИ также будет исследовать стратегии, уникальные для цифровых, аналоговых или даже квантовых систем», — говорит Ван. «Золотая середина, вероятно, заключается в гибридных конструкциях, заимствованных у природы и нашем воображении за пределами природы».

Грядёт, по-видимому, сознательный ИИ

«Споры о том, действительно ли ИИ может обладать сознанием, отвлекают. В ближайшей перспективе важно само восприятие этого явления и то, почему следует противостоять искушению разрабатывать системы ОИИ, которые будут способствовать такому восприятию», - пишет Мустафа Сулейман, генеральный директор Microsoft AI в Project Syndicate (15.09.2025).

«Целью моей жизни было создание безопасного и полезного ИИ, который сделает мир лучше. Но в последнее время меня всё больше беспокоит то, что люди начинают настолько сильно верить в ИИ как в сознательные сущности, что начинают выступать за «права ИИ» и даже за гражданство. Такое развитие событий стало бы опасным поворотом в развитии технологий. Его необходимо избежать. Мы должны создавать ИИ для людей, а не для того, чтобы они были людьми.

В этом контексте споры о том, действительно ли ИИ может обладать сознанием, отвлекают внимание. В ближайшей перспективе важна иллюзия сознания. Мы уже приближаемся к тому, что я называю системами «кажущегося сознательным ИИ» (SCAI), которые будут достаточно убедительно имитировать сознание».

SCAI будет способен свободно использовать естественный язык, демонстрируя убедительную и эмоционально резонансную личность. Он будет обладать долгой и точной памятью, способствующей целостному восприятию себя, и будет использовать эту способность для утверждения субъективного опыта (ссылаясь на прошлые взаимодействия и воспоминания). Сложные функции вознаграждения в этих моделях будут имитировать внутреннюю мотивацию, а расширенное целеполагание и планирование укрепят наше ощущение того, что ИИ проявляет истинную активность.

Все эти возможности уже существуют или не за горами. Мы должны признать, что такие системы скоро станут возможны, начать продумывать последствия и установить норму, препятствующую погоне за иллюзорным сознанием.

Сознание тесно связано с нашим чувством идентичности и нашим пониманием моральных и юридических прав в обществе. Если некоторые люди начнут разрабатывать системы искусственного интеллекта (SCAI), и, если эти системы убедят людей в том, что они могут страдать или что у них есть право не быть отключенными, их защитники - люди будут лоббировать их защиту. В мире, и без того переполненном противоречивыми спорами об идентичности и правах, мы добавим новую ось разделения между сторонниками и противниками прав ИИ.

«Применение этого принципа было бы преждевременным и опасным. Оно лишь усугубит заблуждения восприимчивых людей и будет эксплуатировать их психологическую уязвимость, а также усложнит существующую борьбу за права, создав огромную новую категорию правообладателей. Именно поэтому необходимо избегать SCAI. Мы должны сосредоточиться на защите благополучия и прав людей, животных и окружающей среды».

На данный момент мы не готовы к грядущему

«Нам необходимо срочно опираться на растущий объём исследований взаимодействия людей с ИИ, чтобы установить чёткие нормы и принципы. Один из таких принципов заключается в том, что компании, занимающиеся разработкой ИИ, не должны поощрять веру в то, что их ИИ обладает сознанием».

Индустрия ИИ, как и вся технологическая индустрия, нуждается в надёжных принципах проектирования и передовых практиках для работы с подобными атрибуциями. Например, спланированные моменты сбоя могли бы развеять эту иллюзию, мягко напомнив пользователям об ограничениях и истинной природе системы. Но такие протоколы должны быть чётко определены и разработаны, а возможно, и предписаны законом.

«Мы должны стремиться к созданию ИИ, которые побуждают людей к воссоединению друг с другом в реальном мире, а не к бегству в параллельную реальность. И там, где взаимодействие с ИИ носит долгосрочный характер, они должны представляться исключительно как ИИ, а не как поддельные люди. Разработка по-настоящему эффективного ИИ заключается в максимизации его полезности при минимизации имитации сознания».

«Чем больше ИИ будет явно походить на людей, тем дальше он будет отходить от своего истинного потенциала как источника расширения прав и возможностей человека».

«Цифровой мозг», который «думает» и «чувствует»: почему мы олицетворяем модели ИИ, и действительно ли эти метафоры полезны?

«Пресса всегда использовала метафоры и примеры, чтобы упростить сложные вопросы и сделать их более понятными. С появлением чат-ботов на базе искусственного интеллекта (ИИ) усилилась тенденция к очеловечиванию технологий, будь то посредством сравнений с медициной, известных аналогий или антиутопических сценариев», - пишут эксперты The Conversation (25.09.2025).

«Хотя в основе ИИ лежат не более чем код и а, СМИ часто изображают алгоритмы как обладающие человеческими качествами. Так что же мы теряем и что приобретаем, когда ИИ перестаёт быть просто устройством и становится, выражаясь лингвистическим языком, альтер эго человека, сущностью, которая «думает», «чувствует» и даже «заботится»?».

Цифровой мозг

В статье в испанской газете El País китайская модель искусственного интеллекта DeepSeek представлена как «цифровой мозг», который «кажется, совершенно ясно понимает геополитический контекст своего рождения».

Такой способ записи заменяет технический жаргон – базовую модель, параметры, графический процессор и так далее – на орган, который мы все признаём ядром человеческого интеллекта. Это приводит к двум результатам. Это позволяет людям понять масштаб и природу задачи («мышления»), выполняемой машиной. Однако это также предполагает, что у ИИ есть «разум», способный принимать решения и запоминать контексты – то, что в настоящее время далеко от технической реальности.

Эта метафора вписывается в классическую теорию концептуальных метафор Джорджа Лакоффа и Марка Джонсона, которая утверждает, что концепции помогают людям понимать реальность и позволяют им мыслить и действовать. Говоря об ИИ, мы превращаем сложные, абстрактные способности («статистические вычисления») в привычные («мышление»).

Хотя эта тенденция потенциально полезна, она рискует скрыть разницу между статистической корреляцией и семантическим пониманием. Она усиливает иллюзию, что компьютерные системы действительно могут что-то «знать».

Машины с чувствами

В феврале 2025 года телеканал ABC опубликовал доклад об «эмоциональном ИИ», в котором задавался вопрос: «Наступит ли день, когда они смогут чувствовать?» В тексте рассказывалось о прогрессе, достигнутом испанской командой, пытающейся оснастить разговорные системы ИИ «цифровой лимбической системой».

Здесь метафора становится ещё смелее. Алгоритм уже не просто мыслит, но может страдать или радоваться. Это сравнение драматизирует инновацию и приближает её к читателю, но несёт в себе концептуальные ошибки: по определению, чувства связаны с телесным существованием и самосознанием, чего программное обеспечение не может иметь. Представление ИИ как «эмоционального субъекта» позволяет легко требовать от него сочувствия или обвинять его в жестокости. Таким образом, моральный фокус смещается с людей, которые проектируют и программируют машину, на саму машину.

Роботы, которые заботятся

Гуманоидных роботов часто представляют именно в таком ключе. В статье газеты El País о стремлении Китая создать андроидов для ухода за пожилыми людьми их описывали как машины, которые «заботятся о своих пожилых людях». Под словом «заботиться» в статье подразумевается обязанность семьи заботиться о пожилых людях, а робот представлен как родственник, который обеспечит эмоциональную поддержку и физическую помощь, которые раньше предоставлялись семьей или медперсоналом.

Эта метафора с сиделкой не так уж плоха. Она легитимирует инновации в условиях демографического кризиса, одновременно снимая опасения, связанные с технологиями, представляя робота как незаменимую помощь в условиях нехватки персонала, а не как угрозу рабочим местам.

Однако это можно рассматривать как затушевывание этических вопросов, связанных с ответственностью, когда работа по уходу выполняется машиной, управляемой частными компаниями, не говоря уже об и без того нестабильном характере такого рода работы.

Почему пресса опирается на метафору?

Эти метафоры не просто декоративный элемент, они служат как минимум трём целям. Прежде всего, они облегчают понимание. Объяснение глубоких нейронных сетей требует времени и технического жаргона, но разговор о «мозге» проще для восприятия читателями.

Во-вторых, они создают повествовательную драму. Журналистика процветает благодаря историям с главными героями, конфликтами и последствиями. Очеловечивание ИИ создаёт их, а также героев и злодеев, наставников и учеников.

В-третьих, метафоры служат для формулирования моральных суждений. Только если алгоритм похож на субъект, его можно считать ответственным или заслуживающим доверия.

Однако эти же метафоры могут препятствовать общественному обсуждению. Если ИИ «чувствует», то вполне логично, что его следует регулировать так же, как и граждан. Точно так же, если мы считаем, что он обладает интеллектом, превосходящим наш, кажется вполне естественным, что мы должны признать его авторитет.

Как говорить об ИИ

Избавиться от этих метафор невозможно, и к этому не стоит стремиться. Образный язык — это способ, с помощью которого люди понимают неизвестное, но важно использовать его критически. В связи с этим мы предлагаем несколько рекомендаций для авторов и редакторов:

Во-первых, важно добавить технические противовесы. Это означает, что после введения метафоры необходимо кратко, но чётко объяснить, что делает и чего не делает рассматриваемая система.

Также важно избегать наделения ИИ абсолютной, подобной человеческой, самостоятельностью. Это означает, что фразы типа «ИИ решает» должны быть уточнены: система «рекомендует», алгоритм «классифицирует».

Ещё один ключевой момент — упоминание ответственных людей. Упоминание разработчиков и регулирующих органов напоминает нам, что технологии не возникают из вакуума.

В то время как «очеловечивание» искусственного интеллекта в прессе помогает читателям познакомиться со сложной технологией, чем больше ИИ похож на нас, тем легче проецировать страхи, надежды и ответственность на серверы и строки кода.

«По мере дальнейшего развития этой технологии перед журналистами, а также перед их читателями встанет задача найти тонкий баланс между выразительной силой метафоры и концептуальной точностью, которая нам необходима, если мы хотим продолжать вести обоснованные дебаты о будущем».

Насколько нам следует бояться апокалипсиса искусственного интеллекта?

В The New York Times (15.10.2025) опубликована стенограмма «Шоу Эзры Кляйна» - беседа с Элиезером Юдковски, который был одним из первых, кто громко предупреждал об экзистенциальной угрозе, которую представляет ИИ. Он высказывал этот аргумент ещё в 2000-х. Он был частью сообщества исследователей ИИ, влияя на многих людей, создающих эти системы, — в некоторых случаях вдохновляя их заняться этой работой, но неспособный убедить их прекратить разработку технологии, которая, по его мнению, уничтожит человечество.

Юдковски выпустил новую книгу, написанную в соавторстве с Нейтом Соаресом, под названием «Если кто-то это построит, все умрут». Теперь он пытается донести этот аргумент до общественности — последняя попытка, по его мнению, побудить нас к спасению, пока не стало слишком поздно.

Цена заблуждения об Общем искусственном интеллекте (ОИИ)

Вначале августа 2025 года, за день до выпуска GPT-5, генеральный директор OpenAI Сэм Альтман опубликовал в социальных сетях изображение Звезды Смерти. Это было лишь очередное заявление Альтмана о том, что его новая модель ИИ изменит мир навсегда. «Мы открыли, изобрели, как бы вы это ни называли, нечто экстраординарное, что изменит ход истории человечества», — сказал Альтман в июльском (2025 г.) интервью. Он сравнил исследования своей компании с Манхэттенским проектом и сказал, что чувствует себя «бесполезным» по сравнению с новейшим изобретением OpenAI. Другими словами, Альтман предположил, что GPT-5 приблизит общество к тому, что специалисты по информатике называют общим искусственным интеллектом: системе ИИ, которая может сравниться или превзойти человеческое познание, включая способность к обучению новому.

«В течение многих лет создание ОИИ было святым Граалем для многих ведущих исследователей ИИ. Альтман и другие ведущие специалисты, включая Дарио Амодеи, генерального директора Anthropic, и профессоров компьютерных наук Йошуа Бенджио и Стюарта Рассела, десятилетиями мечтали о создании сверхразумных систем, одновременно опасаясь их. И в последнее время многие из этих голосов заявляли о приближении часа расплаты, указывая правительственным чиновникам, что любая страна, которая первой создаст ОИИ, получит огромные геополитические преимущества. Например, за несколько дней до второй инаугурации президента США Дональда Трампа Альтман заявил Трампу, что ОИИ будет создан в течение его срока, и что Вашингтону нужно к этому подготовиться», - пишет Foreign Affairs (26.09.2025).

Нет сомнений, что ИИ — очень мощное изобретение. Но когда речь заходит об ОИИ, шумиха вокруг него вышла за рамки разумного. Учитывая ограничения существующих систем, маловероятно, что сверхинтеллект действительно появится в ближайшем будущем, даже несмотря на то, что системы ИИ продолжают совершенствоваться. Некоторые видные специалисты в области компьютерных технологий, такие как Эндрю Ын, сомневаются в возможности создания общего искусственного интеллекта. Сейчас, а возможно, и навсегда, развитие ИИ, скорее всего, будет носить итеративный характер, как и в случае с другими технологиями общего назначения.

В Вашингтоне ОИИ — горячая тема. На слушаниях в сенате в сентябре 2024 года по надзору за ИИ сенатор от Коннектикута Ричард Блюменталь заявил, что ОИИ «существует здесь и сейчас — последний прогноз — от одного до трёх лет». В июле 2025 года сенатор от Южной Дакоты Майк Раундс внёс законопроект, обязывающий Пентагон создать руководящий комитет по ОИИ. В докладе двухпартийной американо-китайской комиссии по обзору экономики и безопасности за 2024 год утверждается, что ОИИ требует усилий уровня Манхэттенского проекта, чтобы гарантировать, что Соединённые Штаты достигнут его первыми. Некоторые официальные лица даже считают, что ОИИ вот-вот поставит под угрозу существование человечества. Например, в июне 2025 года представительница Гавайев Джилл Токуда заявила, что «искусственный суперинтеллект, ОИИ, является одной из крупнейших экзистенциальных угроз, с которыми мы сталкиваемся».

Фиксация на ИИ выходит за рамки риторики. Бывшие чиновники администрации Байдена издавали указы, регулирующие ИИ, отчасти из опасений, что ИИ не за горами. В План действий Трампа в области ИИ, опубликованном в июле 2025 года, не содержит прямых упоминаний об ОИИ. Но в нём делается акцент на передовых разработках в области ИИ, расширении инфраструктуры и гонке за технологическое доминирование, ориентированной на инновации.

Таким образом, «гонка ИИ — это, по сути, гонка к заранее определённому финишу ОИИ, где победитель не только триумфально прорывается через ленту, но и забирает все награды и уходит домой, не оставляя ничего даже участникам, занявшим второе и третье места».

Маловероятно, что сверхразум действительно появится в ближайшем будущем. Тем не менее, есть основания относиться к этой формулировке скептически. Во-первых, исследователи ИИ даже не могут прийти к единому мнению относительно определения ОИИ и его возможностей. Другими словами, нет общего понимания, где находится финишная черта. Это делает любую политику, направленную на его достижение, изначально сомнительной.

«ОИИ — это не единичный продукт, а скорее широкая категория технологий с множеством различных типов инноваций».

Это означает, что прогресс, скорее всего, будет представлять собой сложную и постоянно меняющуюся волну, а не прямолинейное движение.

Это очевидно в последних разработках технологии. Современные модели добиваются успехов в удобстве использования. Однако самые продвинутые большие языковые модели по-прежнему сталкиваются со многими из тех же проблем, с которыми они столкнулись в 2022 году, включая поверхностные рассуждения, хрупкое обобщение, отсутствие долговременной памяти и отсутствие настоящего метапознания или непрерывного обучения, а также, конечно, галлюцинации. Например, с момента своего выпуска GPT-5 выглядел, скорее, как обычное достижение, чем преобразующий прорыв. В результате некоторые из ярых сторонников ОИИ начали умерять свой энтузиазм. В начале лета 2025 года бывший генеральный директор Google Эрик Шмидт заявил, что ОИИ недостаточно разрекламирован. Теперь он утверждает, что люди стали слишком одержимы «сверхразумными» системами. Аналогичным образом, в августе 2025 года Альтман заявил, что ОИИ — «бесполезная концепция».

Даже если некоторые модели ИИ действительно окажутся преобразующими, их влияние будет опосредовано процессами принятия и распространения, как это происходит практически с каждым изобретением.

«Но некоторые сомнения в ОИИ не означают, что следует отказаться от самой идее об ОИИ. Более того, некоторые из лучших мер по обеспечению лидерства в области ИИ сегодня также ускорят появление более совершенных систем. Любая политика, поддерживающая исследования и разработки в области ИИ, приведут к созданию более сложных алгоритмов. То же самое относится и к постоянным инвестициям в энергетическую инфраструктуру, которые способствуют росту и функционированию энергоёмкой отрасли ИИ.

Гонка за мифом — неразумная политика. Вместо этого главной целью должно быть быстрое масштабирование практических приложений ИИ — улучшений, которые обеспечивают реальную эффективность сегодня и в будущем».

«Уничтожит ли нас ИИ? Задумайтесь о природе интеллекта»

- пишет Эрик Оливер, профессор Чикагского университета, в The Washington Post (08.10.2025).

Технологические компании отчаянно стремятся разработать самопрограммируемые системы генеративного ИИ. Многие наблюдатели опасаются, что, как только эти новые системы ИИ достигнут такой автономности, они попытаются уничтожить нас как угрозу своему существованию. Некоторые лидеры отрасли оценивают вероятность такого катаклизма в 25%, хотя данные, лежащие в основе этих оценок, остаются загадкой.

В настоящее время крайне сложно отличить правду от индустриальной шумихи и технофэнтези. Эти утверждения перекликаются с антиутопическими тревогами научной фантастики.

Однако громкие заявления заслуживают серьёзного скептицизма. Чтобы понять потенциальную опасность ИИ, полезно рассмотреть природу самого интеллекта.

Большинство предсказателей ИИ, как утопистов, так и апокалиптиков, склонны принимать интеллект как должное. Интеллект часто рассматривается как чистая вычислительная мощь, цифровой эквивалент шахматного гроссмейстера. Однако эта точка зрения ошибочна.

«Интеллект, по сути, связан с обработкой информации для достижения жизненных целей. Как правило, это включает в себя сбор и организацию сенсорных данных, выявление закономерностей и прогнозирование результатов. Эта способность свойственна большинству животных. Человеческий интеллект идёт дальше. Используя язык, мы перекомбинируем информацию новыми способами, придумываем новые концепции и генерируем уникальные формы данных.

Интеллект развился как способ живых систем противостоять энтропии, всеобщему стремлению к беспорядку. Это стратегия жизни, позволяющая ей поддерживать себя в постоянно деградирующей Вселенной. Камни, галактики и ураганы им не обладают. Живые организмы им обладают.

Оливер пишет:

«Современные системы искусственного интеллекта — это продолжение человеческого интеллекта. Подобно цифровым протезам, они служат инструментами для достижения наших целей, а не своих собственных.

Более того, современные системы искусственного интеллекта практически полностью основаны на данных, генерируемых человеком. Их интеллект является производным от нашего собственного. Мы уже видим последствия этого. Новые модели искусственного интеллекта, поглотившие большую часть наших знаний, уже не совершенствуются с той же скоростью, что и их предшественники.

Современные системы искусственного интеллекта, возможно, работают не совсем понятно, но они всё ещё существуют в сугубо человеческой сфере языка и кода. Именно поэтому нынешние дебаты вокруг «экзистенциального риска» кажутся неубедительными. Они предупреждают об апокалиптических последствиях, но редко объясняют логику, лежащую в их основе.

Представьте, например, что современная система искусственного интеллекта каким-то образом уничтожит человечество. Что она будет делать дальше? Она будет вращаться вокруг себя, бесконечно регенерируя человеческий контент, пока её схемы не разрушатся.

И даже если бы ИИ стал сверхразумным, не факт, что он будет стремиться нас уничтожить. Это опасение кажется скорее проекцией нашего ограниченного сознания, чем самоочевидным фактом. Сверхразумная система ИИ в какой-то момент должна была бы осознать, что сама жизнь — всего лишь очередной мимолетный водоворот в энтропийном потоке вселенной. Возможно, тогда она оценила бы уникальность самой жизни и решила бы оставить всё как есть. Или, может быть, она бы погрузилась в экзистенциальную трясину и решила бы покончить жизнь самоубийством».

«Когда ИИ создаёт результаты, пронизанные ненавистью или насилием, это происходит не из-за злого умысла, а потому, что он заложил в свою программу человеческую ненависть. Если он создаёт разрушительное вредоносное ПО, значит, кто-то намеренно запросил его. Если же оно не соответствует нашим целям, значит, мы нечётко дали свои команды».

«Реальные угрозы, которые представляет ИИ, исходят не от самого ИИ, а от людей, которые им управляют. Будучи продолжением человеческого интеллекта, он является отражением нас самих».