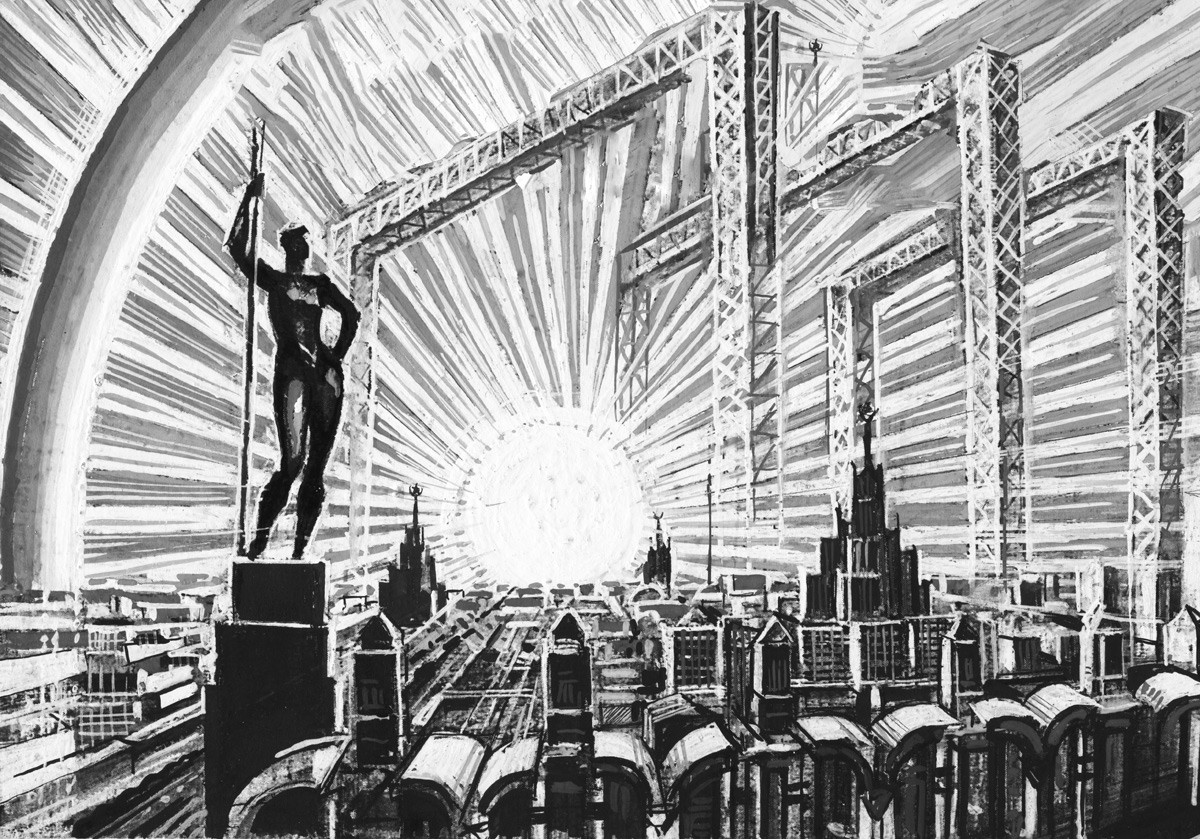

25 октября 2025 года Генеральный прокурор РФ Александр Гуцан по поручению Президента России Владимира Путина подписал в Ханое (Вьетнам) Конвенцию ООН против киберпреступности.

Вместе с Россией Конвенцию подписали ещё более 60 стран. Она открыта для подписания до конца 2026 года.

В.В. Путин назвал подписание Конвенции историческим событием. Ведь впервые на мировом уровне создан механизм международно – правового сотрудничества по борьбе с преступлениями в информационно – коммуникационных системах. И инициатором разработки Конвенции стала Россия еще в 2019 году. Первый проект Конвенции также внесла Россия в 2021 году. В декабре 2024 года Конвенция была принята резолюцией Генеральной ассамблеи ООН. И теперь состоялось подписание.

Безусловно, Конвенция станет базовым документом в борьбе с киберпреступностью. Но, ситуация в киберсфере настолько стремительно развивается, что уже сейчас надо думать о дальнейшем развитии международно – правовых инструментов.

Многие специалисты по борьбе с киберпреступностью ставят вопрос о разработке специального протокола к Конвенции, касающегося вопросов искусственного интеллекта.

Организации по всему миру стремительно внедряют искусственный интеллект (ИИ), в том числе на уровне корпораций, где он уже обеспечивает значительный рост эффективности. В результате кибербезопасность вступает в переломный момент, когда ИИ борется с ИИ. Современные фишинговые атаки и дипфейки — лишь предвестники грядущей эры автономных, самооптимизирующихся ИИ-атак. Системы, способные планировать, осуществлять и совершенствовать атаки с ограниченным контролем со стороны человека или даже без него.

Известная компания киберзащиты Check Point Research в публикации «ИИ 2030: грядущая эра автономной киберпреступности» (24.10.2025) пишет о своём новом исследовании:

«В сентябре 2025 года глобальная аналитика киберугроз обнаружила, что 1 из 54 запросов генеративного ИИ (GenAI) из корпоративных сетей представляет высокий риск раскрытия конфиденциальных данных, затрагивая 91 процент организаций, которые регулярно используют инструменты ИИ.

Эта статистика показывает, что ИИ не просто меняет производительность, он меняет правила киберрисков».

Расширяющаяся поверхность атак ИИ: четыре критических вектора угроз, которые организациям следует учитывать

По мере того, как искусственный интеллект и генеративный ИИ глубоко интегрируются в современные бизнес-процессы, они также трансформируют ландшафт киберугроз. Злоумышленники больше не полагаются исключительно на традиционные инструменты — они внедряют ИИ в свою тактику, методы и процедуры для запуска более масштабируемых, адаптивных и сложных кампаний. Следующие четыре вектора уже формируются в современной экосистеме ИИ и представляют собой некоторые из наиболее актуальных проблем безопасности для организаций в 2025 году и в дальнейшем.

Первый вектор: атаки с использованием автономного ИИ: кампании по борьбе с угрозами, управляемые машинами

Киберпреступники всё чаще экспериментируют с автономными атаками на основе искусственного интеллекта, где роботы-агенты самостоятельно планируют, координируют и реализуют многоэтапные кампании. Эти системы ИИ обмениваются данными, адаптируются к мерам защиты в режиме реального времени и взаимодействуют на тысячах конечных точек, функционируя подобно самообучающимся ботнетам без человеческого контроля.

Недавние примеры показывают, как автономный ИИ может объединить разведку, эксплуатацию и кражу данных в единую цепочку. Эта эволюция, осуществляемая с машинной скоростью, представляет собой серьёзную проблему для центров безопасности (SOC), которые рискуют быть перегруженными потоками адаптивных, самоорганизующихся атак, генерирующих тысячи оповещений, проверяющих политики и меняющих тактику в режиме реального времени.

Второй вектор: адаптивное создание вредоносного ПО: саморазвивающийся вредоносный код

В 2024 году на нескольких подпольных форумах начали рекламироваться «генераторы вредоносного ПО на основе ИИ», способные автоматически писать, тестировать и отлаживать вредоносный код. Эти инструменты используют циклы обратной связи для определения вариантов, которые обходят обнаружение, превращая каждую неудачную попытку в топливо для следующего успеха.

Использование полиморфного вредоносного ПО, созданного с помощью искусственного интеллекта, меняет подход злоумышленников к созданию и развертыванию вредоносного ПО. Если традиционные вредоносные программы полагались на незначительные изменения кода для обхода обнаружения, то современные генеративные модели — от GPT-4o до LLM с открытым исходным кодом — теперь позволяют создавать уникальные, функциональные варианты вредоносного ПО за считанные секунды.

Третий вектор: синтетические внутренние угрозы - имитация личности с использованием искусственного интеллекта и социальная инженерия

Угроза инсайдерской атаки стремительно развивается с появлением искусственных личностей и персонажей, сгенерированных искусственным интеллектом. Созданные на основе украденных данных сотрудников, образцов голоса и внутренних сообщений, эти агенты ИИ могут убедительно имитировать реальных пользователей, отправляя электронные письма, выглядящие как настоящие, подключаясь к видеозвонкам с имитацией голоса и проникая на платформы для совместной работы, используя точные лингвистические и поведенческие шаблоны.

Недавние случаи «взлома вибрации» продемонстрировали, как злоумышленники внедряли методы социальной инженерии непосредственно в конфигурации ИИ, позволяя ботам вести переговоры, обманывать и существовать автономно. Поскольку клонирование голоса с помощью ИИ становится неотличимым от настоящего, верификация личности сместится с определения говорящего на последовательность его действий, что станет фундаментальным изменением в моделях цифрового доверия.

Четвёртый вектор: цепочка поставок ИИ и отравление моделей - компрометация ядра

Стремительное внедрение сторонних и открытых моделей ИИ создало обширную новую поверхность для атак: цепочку поставок ИИ. В 2025 году несколько исследовательских лабораторий продемонстрировали атаки с искажением данных, при которых изменение всего 0,1% данных для обучения модели могло привести к целенаправленной ошибочной классификации — например, к указанию системе машинного зрения на основе ИИ ошибочно принять знак «Stop» за знак ограничения скорости. В контексте кибербезопасности это может означать, что модель обнаружения вторжений ошибочно классифицирует вредоносную полезную нагрузку как безвредную.

Чем эти угрозы ИИ отличаются

Кибератаки с использованием искусственного интеллекта отличаются тем, что они сочетают в себе скорость, автономность и интеллект в масштабах, с которыми не могут сравниться злоумышленники-люди.

В отличие от традиционных угроз, атаки, созданные с помощью машин, постоянно обучаются и адаптируются. Каждый неудачный эксплойт становится учебным набором данных, создавая самосовершенствующуюся экосистему угроз, которая развивается быстрее, чем традиционные средства защиты. Check Point Research отмечает, что некоторые инструменты на основе ИИ были превращены в оружие за считанные часы для эксплуатации «уязвимостей нулевого дня».

Эти атаки также работают с беспрецедентной точностью. Генеративный ИИ позволяет использовать персонализированный фишинг, многоязычные дипфейки и создавать синтетические инсайдерские персоны, которые настолько точно имитируют тон и поведение, что обходят как человеческие подозрения, так и автоматизированные фильтры. При этом ИИ-исполнение удаляет «человеческие отпечатки», такие как опечатки, различия во времени или лингвистические следы. Это значительно затрудняет атрибуцию и обнаружение.

Наконец, ИИ «демократизирует» киберпреступность. Инструменты, автоматизирующие сканирование, эксплуатацию и согласование, снижают барьеры для менее квалифицированных злоумышленников, расширяя спектр угроз. К 2030 году программы-вымогатели и кража данных будут практически полностью контролироваться автономными системами ИИ, способными выполнять операции круглосуточно и без участия человека.

На что надо обратить внимание на национальном и международном уровнях?

Чтобы снизить риск и обеспечить долгосрочную устойчивость, следует сосредоточиться на следующих четырех основных стратегиях:

Выбирать платформы ИИ, созданные или настроенные с учётом принципов безопасности;

Формировать принципы работы больших языковых моделей (LLM), включая запросы, которые ссылаются на валидацию, шифрование и безопасные значения по умолчанию, чтобы безопасные методы были интегрированы с самого начала;

Всегда ограничивать объём данных, предоставляемых инструментам ИИ, сохраняя конфиденциальные файлы, учётные данные или рабочие наборы данных вне досягаемости;

При необходимости тестирования использовать очищенные или синтетические данные и проверять разрешения, чтобы ИИ получал доступ только к необходимым данным.

Внедрение концепции «нулевого доверия» для ИИ

Важно применять принцип минимальных привилегий к системам ИИ. Аутентифицировать каждый вызов API, обеспечивать непрерывную проверку и отслеживайте взаимодействие между ИИ для предотвращения горизонтальных перемещений.

Весь код, генерируемый ИИ, должен проходить экспертную оценку, тестирование и сканирование на уязвимости перед развертыванием. Человеческий контроль обеспечивает надлежащее соблюдение требований логики, безопасности и соответствия требованиям, а также помогает выявлять тревожные сигналы, которые ИИ может пропустить.

Управление использованием GenAI в масштабах всей компании

Неконтролируемое использование инструментов ИИ становится растущим источником утечки данных. Исследование статистики кибератак, проведенное Check Point Research в сентябре 2025 года, показало, что 15% запросов корпоративного ИИ содержали потенциально конфиденциальную информацию, такую как данные о клиентах и проприетарный код.

Создание устойчивости к эпохе ИИ

Гонка вооружений в сфере ИИ началась, и рост утечек данных GenAI показывает, насколько быстро автоматизация меняет представление о рисках для предприятий по всему миру. В перспективе развитие ИИ не просто ускорится — оно фундаментально изменит подход организаций к обеспечению своего цифрового будущего.

Ландшафт угроз стремительно меняется: от синтетических инсайдеров, выдающих себя за сотрудников, до адаптивного вредоносного ПО, переписывающего собственный код. Облачные платформы на базе искусственного интеллекта, ориентированные на предотвращение атак, сегодня играют ключевую роль, интегрируя предиктивную аналитику, поведенческий интеллект и автономное устранение последствий для предотвращения угроз до их возникновения.

В сфере безопасности необходимо перейти от реактивных инструментов к облачным платформам на базе искусственного интеллекта, которые предсказывают и предотвращают атаки до их возникновения, интегрируя аналитику на основе информации об угрозах, автономное устранение последствий и непрерывное управление.

Будущее кибербезопасности будет принадлежать тем, кто примет на вооружение этот платформенно-ориентированный подход, консолидируя прозрачность и контроль во всем цифровом пространстве и внедряя принципы «нулевого доверия» и безопасности на каждом уровне, превращая ИИ из риска в решающее преимущество.

***

Безусловно, мнение одной компании – это не истина в последней инстанции. Но ясно одно – реализация Конвенции против киберпреступности требует постоянного наращивания совместных усилий по защите общества и граждан на новых направлениях противодействия киберугрозам.