Политики, которые говорят то, чего никогда не могли бы сказать, звезды кино первой величины, вдруг снявшиеся в порнофильме… Благодаря новой технологии дипфейк это больше не антиутопия, а повседневная реальность. Любой, кому доступны записи выступлений публичных персон и компьютерные программы, использование которых почти не ограничено законами, отныне может заставить человека говорить чужие слова, а мертвых поднять из могил. Конечно, не в буквальном смысле, а в «цифре», на уровне голоса и внешности, но и это настоящий прорыв в будущее. Пока эффективные системы защиты от дипфейков не созданы, выглядит такое будущее весьма устрашающе.

Опасность родом из ХХ века

Технология, способная заменить человеческую внешность и голос в цифровой аудио- и видеопродукции, получила название дипфейк (англ. deepfake): от сочетания deep learning («глубокое обучение», один из ключевых инструментов при разработке искусственного интеллекта) и fake («подделка»). Ее главное отличие от традиционных способов компьютерной графики – использование нейросетей, способных обучаться самостоятельно. Человеку нужно лишь давать программным алгоритмам критерии: что правильно, а что – нет, успешно ли выполнена задача. Первую искусственную нейросеть создали нейропсихолог Уоррен Мак Каллок и нейролингвист Уолтер Питтс еще в 1943 году. А в 1960‑м психолог и нейрофизиолог Фрэнк Розенблатт представил миру первый созданный под нейросети компьютер «Марк‑1», способный с помощью фотоэлементов считывать и распознавать написанные от руки числа.

Однако дальнейшее усовершенствование нейросетей стало возможно только при аналогичном росте вычислительных мощностей и массовом распространении интернета. Производительные компьютеры и накопленный массив «больших данных» (Big Data – статистика, закономерности поведения пользователей и так далее) позволили нейросетям проникнуть в сетевые сервисы и персональные устройства. Нейросети обучаются не в пример быстрее человека. Скорость сильно зависит от мощности ПК, на которых производятся вычисления, в середине 2010‑х она исчислялась годами, сегодня – зачастую месяцами. После обучения нейросеть способна выполнять функции голосового помощника (Siri, Google Ассистент, Яндекс.Алиса и др.), обрабатывать фотографии прямо во время съемки на камеру смартфона. И вот новая возможность: подменять голос и внешность человека на видео. Причем даже не обязательно в записи – в прямом эфире тоже получится. Для обучения трюку Cеть анализирует гигабайты исходных данных: внешность человека, мимику, голос, интонации. Параллельно она пытается их имитировать, а команда разработчиков контролирует и направляет процесс. В результате уже сегодня в Сети можно встретить ролики, идентичные натуральным, с настоящими людьми, которые говорят и делают то, чего никогда не могли бы сделать.

Первые пострадавшие

Впервые дипфейки привлекли внимание общественности в конце 2017 – начале 2018 года, когда вдруг претворились в жизнь пубертатные грезы многих подростков: суперзвезды кино Натали Портман, Эмма Уотсон, Галь Гадот и Натали Дормер оказались героинями порнороликов. Даже супругу экс-президента США Мишель Обаму не миновала эта участь. В силу абсурдности происходящего на видео, а также из-за несовершенства технологий подмены довольно быстро стали очевидны, а пользователи Сети задались вопросом: что же, собственно, произошло? Именно тогда и возник наибольший интерес к дипфейкам, согласно статистике Google, анализирующей частоту поисковых запросов: так называемый коэффициент интереса достиг 100%. Сегодня он составляет 54% (точное количество запросов поисковая компания не раскрывает). По данным компании Deeptrace, специализирующейся на кибербезопасности, в октябре текущего года в Сети было опубликовано около 15 тысяч дипфейковых роликов. Это вдвое больше по сравнению с декабрем 2018‑го. Из них 96% – порнография. Но даже ХХХ-контент относительно «безобиден» по сравнению с тем, что технология может натворить в руках крупных мошенников. В конце августа 2019 года Wall Street Journal сообщил, что управляющий директор неназванной британской энергетической корпорации отправил злоумышленникам 220 тысяч евро, поскольку ему так по телефону велел сделать босс. Голос начальника был подделан с помощью нейросетей.

Более того, дипфейки могут в буквальном смысле влиять на судьбу государств и народов, вмешиваясь в политическую борьбу накануне президентских выборов. В США они пройдут меньше чем через год, 3 ноября 2020‑го. И для создателей поддельных роликов весьма удачно, что нынешний президент Штатов –эпатажный Дональд Трамп, который может высказываться резко и неожиданно. Он уже становился объектом дипфейков. В мае 2018‑го в Сети появился созданный Бельгийской социалистической партией ролик, где Трамп якобы призывает «народ Бельгии» отказаться признать Парижские соглашения по климатическому урегулированию. А в октябре текущего года «фальшивый Трамп» в ролике французской благотворительной организации Solidarite` Sida заявил о том, что СПИД побежден раз и навсегда. В обоих случаях авторы оставляют упоминание о том, что видео – подделка. Задачей было привлечение внимания общественности, в том числе местных политиков, к определенным проблемам. Технически ролики тоже несовершенны – увидеть подмену можно невооруженным глазом. Именно это пока не позволяет появиться убедительным подделкам, которые могут уничтожить репутацию кандидата в президенты или звезды кино раз и навсегда. Тем не менее прогресс налицо: дипфейки развиваются, и уже сегодня в некоторых случаях отличить оригинал от подделки очень сложно. По крайней мере, без специального ПО, которое пока отсутствует. Очевидно, пора принимать серьезные меры, но какие?

двойной клик - редактировать изображение

Разоблачить фальшивку

Пока единственный известный законопроект, окрещенный «анти-дипфейковым», представлен в Калифорнии (США). В начале октября стало известно, что губернатор штата Гэвин Ньюсом подписал проект AB 730, согласно которому в Сеть запрещено выкладывать ролики с политическими кандидатами за 60 и менее дней до начала выборов. Эксперты уверены, что законопроект консервативен и малоэффективен, его явно будет недостаточно. В первую очередь любой срок с привязкой к выборам выглядит нелогичным, поскольку видео в Сети могут быть загружены заранее и распространяться вирусным образом в течение месяцев и даже лет. Под закон попадут ролики, создание которых продиктовано наличием «злого умысла». Но в американских реалиях доказать его наличие – дело длительных, иногда до нескольких лет, судебных процессов, на протяжении которых ролик продолжит свое существование. Наконец, отвечать перед законом предстоит создателям ролика, тогда как платформа, на которой он размещается, будто бы и не несет ответственности.

Иными словами, первый законодательный блин комом. По сути, контролировать распространение дипфейков техническими методами сегодня невозможно. Правда, крупнейшие IT-корпорации – Google, Microsoft и Facebook – активно работают в этом направлении. Будучи ведущими игроками на рынках интернет-поиска, операционных систем и соцсетей соответственно, именно эти компании в первую очередь занимаются сбором «больших данных» для противостояния дипфейкам. Но пока ни один инструмент не может гарантировать стопроцентный результат. Профессор Университета Южной Калифорнии Хао Ли (Hao Li), разрабатывающий алгоритмы по определению дипфейков, говорит, что лучший результат, которого удалось добиться в экспериментальных условиях, – определение подделки с вероятностью 97%. Остается лакуна в 3%, соответственно, минимум 500 всех загруженных сегодня дипфейк-роликов не могут быть распознаны с помощью алгоритмов. Для интернета, где даже одно вирусное видео может повлиять на репутацию человека, это большая цифра. А с ростом количества и качества дипфейков их определение и вовсе кажется первоочередной задачей специалистов по кибербезопасности.

В конечной перспективе противостоять дипфейкам, в основе которых лежат нейросети, смогут лишь другие нейросети. Но поскольку и тем, и другим для обучения требуется большое количество данных (чем больше, тем лучше), дипфейки на этом поле заведомо побеждают. Им доступны миллиарды видеозаписей, тогда как программы распознавания могут работать лишь с теми 15 тысячами фальшивок, которые сегодня загружены в Сеть, и с собственными экспериментальными дипфейк-нейросетями, как это делается в Университете Южной Калифорнии. Удастся ли отыграть у «поддельной индустрии» стартовую фору? Пока это кажется маловероятным…

Бизнес на цифровых костях

Между тем новую технологию взял на вооружение и вполне легальный бизнес. Поскольку использование дипфейков сегодня не регламентировано ни в одной стране мира, кинопродюсеры чувствуют себя довольно свободно в их применении. В Сети набирают популярность нарезки из фильмов, где актеров меняют местами. Например, ролик от студии Ctrl Shift Face, где Арнольда Шварценеггера в роли Терминатора заменил Сильвестр Сталлоне, с начала июня набрал более трех миллионов просмотров. Киномагнаты видят в дипфейк-технологии возможность, которой раньше у них не было: «воскрешать» умерших звезд. Как правило, такой прием используется для завершения сюжетных линий в киносагах: можно вспомнить «Звездные войны» (Кэрри Фишер погибла в 2016 году, но появится в новом фильме 2019‑го), «Форсаж» (Пол Уокер погиб в 2013 году, появился в фильме 2015‑го). А авторы фильма «Изгой-один. Звездные войны: Истории» (2016) вернули на экраны актера, который умер в 1994‑м, чтобы убедительнее связать между собой серии киносаги.

двойной клик - редактировать изображение

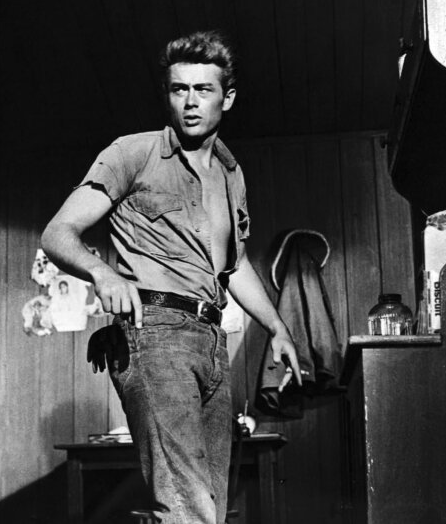

Режиссеры Антон Эрнст и Тати Голик для новой картины о войне во Вьетнаме собираются «воскресить» Джеймса Дина – легенду американского кино середины ХХ века. Тем не менее другие актеры выступили с резкой критикой такого решения. «Это ужасно. Может, компьютер напишет для нас новую картину Пикассо. Или несколько новых песен Джона Леннона. Полное непонимание, позор», – заявил Крис Эванс. «Никто не верил, что индустрия опустится до такого, как только ей станут доступны эти технологии. Использование мертвых в качестве марионеток – ужасный прецедент», – считает Зельда Уильямс.

Пока с этическим аспектом ясности нет, для юристов все сводится к получению разрешения от родственников покойной звезды использовать ее образ в «псевдосъемках» (кстати, потомки Джеймса Дина оказались не против). Важен и контекст: к использованию образа Пола Уокера в фильме «Форсаж 7» общественность отнеслась позитивно, ведь это было сделано для того, чтобы достойно попрощаться с погибшим актером. А чтобы образ в фильме был максимально убедителен, статистами выступили его братья Калеб и Коди Уокеры. Российские разработчики стараются не отставать от IT-моды. К 40‑летию со дня смерти Владимира Высоцкого в июле 2020 года для посетителей Театра на Таганке откроется новое развлечение: можно будет прийти и пообщаться с легендой. Голос певца будут воспроизводить нейронные сети российской разработки Vera Voice. Ответы, вероятно, будут генерироваться искусственным интеллектом, но такие подробности авторы технологии (компания Screenlife Technologies и проект «Робот Вера») пока не раскрывают. К слову, в конце октября команда Vera Voice уже попала в сферу внимания СМИ. В Сети был опубликован демонстрационный ролик, в котором голосами Владимира Путина, Ксении Собчак и Владимира Познера говорится о том, что к подобным технологиям следует относиться с большой осторожностью и ответственностью. Этот же ролик показал новые возможности для знаменитостей: с помощью дипфейков они могут еще эффективнее зарабатывать на своем голосе и внешности. Подписал контракт и – вуаля! – через месяц ты уже озвучил новую рекламу, а то и снялся в новом блокбастере. Даже на съемочную площадку приезжать не пришлось, все сделал статист в цифровой маске.

В общем, странное нас ожидает будущее, особенно если компании из сферы кибербезопасности не найдут способы автоматически отслеживать и маркировать дипфейки. В конце концов, рассчитывать на то, что каждый создатель подобных роликов будет любезно помечать: «Осторожно, подделка!», по меньшей мере наивно. Но других верных способов отличить настоящую запись от фальшивой пока не существует.

Макс Дворак

Источник: журнал "Профиль" №44 2019

-

Оляша

Оляша

27 июня 2020 в 15:22Няша

текст ссылки

-

Оляша

Оляша

27 июня 2020 в 15:22Няша

https://zavtra.ru/books/fal_shivie_gosti_iz_budushego

-

Оляша

Оляша

27 июня 2020 в 15:23Няша

https://2captcha.com/

-

Оляша

Оляша

27 июня 2020 в 15:23Няша

[url]https://stopperhot.com[/url]

-

Оляша

Оляша

27 июня 2020 в 15:23Няша

[url=https://stopperhot.com]fg[/url]